Świrski: Dekarbonizacja destabilizuje energetykę

Projektantom dawnych technologii energetycznych nigdy nie przyszłoby do głowy, jak będą pracować bloki w końcówce swojego istnienia, bo pierwsze założenia pracy były nieco inne niż dziś. Technologia produkcji energii poprzez przekształcenie energii chemicznej paliwa w parę ma swoje praźródła w wynalazkach tzw. bani Herona (już 140 lat p.n.e.) i pierwszych zastosowaniach w starożytności. Następnie w 1681 roku, francuski wynalazca- Denis Papin, którego uważa się umownie z ojca wynalazku kotła energetycznego, zaprezentował tzw. „kociołek Papina”. Potem poszło już szybciej i w XIX wieku powstały koncepcje budowy kotłów, w których woda podążała rurami i odbierała ciepło od spalanego węgla, a w 1856 Stephen Wilcox – potem jeden z założycieli Babcock & Wilcox – opatentował mechanizm kotła wodnorurowego – pisze prof. nzw.dr hab. inż. Konrad Świrski z Politechniki Warszawski, prezes Transition Technologies.

Na początek węgiel długo spalano „taki jaki był” z kopalni, w odpowiednikach, wciąż stosowanych kotłach rusztowych, aby na początku XX wieku przejść w erę kotłów pyłowych – wykorzystując pomysł mielenia węgla na drobny pył w celu spalania mieszanki pyłowo-powietrznej. Pierwszy blok w tej technologii zbudowano w latach 1918-20 w Qneida Street Power Plant – w The Milwaukee Electric Railway & Light Company- obecnie jest to korporacja Wisconsin Electric właśnie w stanie Wisconsin. Okazało się, że wstępne mielenie węgla pozwala prowadzić proces spalania w sposób znacznie bardziej efektywny jak również pozwala na wykorzystywanie znacznie gorszych jakościowo węgli. Taka konstrukcja okazała się zwycięska w światowej energetyce węglowej. Kolejne poprawki tej technologii doprowadziły do obecnego standardu budowy bloków, gdzie stopniowo podwyższano parametry pary (do ultraktytycznych obecnie) i skutecznie obroniono dominację kotłów pyłowych przy atakach technologii fluidalnych czy też prób zgazowania węgla.

Co ciekawe, zaraz na początki drogi „pyłowego” spalania, próbowano także użyć ten koncept w węglowych lokomotywach albo na statkach (niemiecki „Nicea” w latach 30-tych). Jednak tu wymogi ciągłych, szybkich zmian obciążenia (a szczególnie pracy na niskim obciążeniu) stały się barierą i wkrótce technologie węglowe w transporcie zostały wyparte przez wygodniejszą w użyciu benzynę lub olej napędowy i rozwijały się już tylko w energetyce. Bowiem w dawnej energetyce, proces produkcji energii w dużych blokach uważano raczej za stosunkowo stały, samo uruchomienie kotła energetycznego (ze stanu zimnego) trwa około 10-12 godzin, bo niemożliwe jest szybkie nagrzanie metalowych elementów grubościennych, więc raczej próbowano produkować energie (po uruchomieniu) już w sposób ciągły i zwykle na jednym, wysokim poziomie obciążenia. Taki (znamionowy) wysoki poziom pracy kotła (i bloku energetycznego z kotłem pyłowym) jest zwykle optymalny sprawnościowo, aczkolwiek da się zmieniać moc i zakres regulacyjności tego typu bloków do ok. 55-100% obciążenia- zejść jeszcze niżej nie jest łatwo z uwagi na problemy ze stabilnym spalaniem w kotle.

Ewolucja polskiego systemu energetycznego

Gwałtowne przyspieszenie w polskiej energetyce zaczęło się w latach 60-tych, kiedy forsowana industrializacja wymusiła gwałtowne zapotrzebowanie na energię elektryczną. Około roku 1960 wystarczało niewiele ponad 7,5 tys. MW w elektrowniach, ale już wkrótce, w latach osiemdziesiątych nawet ok. 33 tys. MW polskiej energetyki, nie wystarczało i pojawiały się chwilowe ograniczenia w dostawach (stopnie zasilania). W praktyce wszystkie moce poszły w węgiel i w dominującą właśnie technologię kotłów pyłowych. Kiedy budowano elektrownie, nikt nie zdawał sobie sprawy z tego, że bloki trzeba będzie zatrzymywać z innych powodów niż stany awaryjne i remonty, bo energii zawsze brakowało, a regulacje zakładano jako zjazd na niższe obciążenia w części bloków podczas tzw. doliny nocnej.

Powoli sytuacja się zmieniała

Z czasem, w latach 90-tych i później, mało oszczędne wykorzystanie energii w przemyśle ciężkim odeszło do lamusa- bo i ten przemysł padł- a polski system energetyczny zaczął pokazywać nieoczekiwane nadwyżki mocy. Dodatkowe modernizacje z lat 90-tych (m.in. w kierunku ograniczenia emisji substancji szkodliwych – NOx, SO2, pyły) jak i środki z tzw. Kontraktów Długoterminowych (ówczesnego wynalazku, który jak nic przypomina obecny, europejski „capacity market”) pozwoliły na upgrade i nowe życie starych jednostek i tak w nowy wiek wkroczyliśmy z flotą kotłów pyłowych i elektrowni węglowych.

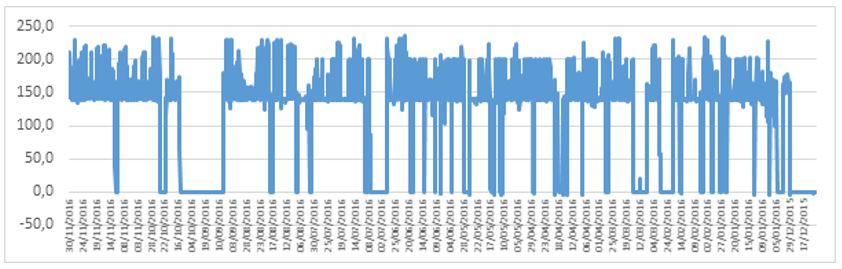

Przez chwilę próbowano wprowadzić pewną dywersyfikację za pomocą elektrowni gazowych (na ich potrzeby była planowana m.in. druga nitka gazociągu jamalskiego, który potem poszedł w Nordsteam), ale wysokie ceny gazu, załamały pierwszą falę budowy bloków gazowo-parowych, które opanowany tylko 2% mocy w systemie. Jednak to była tylko przygrywka. Nikt nie przewidywał w okolicach roku 2000, że wszystko zmieni się tak diametralnie. Na początku przyszła liberalizacja rynku energii- koncepcja rynkowej sprzedaży, a nie centralnego sterowania produkcją. Okazało się, że nie ważne jak się produkuje, ale jak się sprzedaje, wobec czego bloki energetyczne musiały się przystosować do wymogów kontraktów sprzedażowych- a więc różnego poziomu obciążenia i nawet odstawień. Dalej, jak w dobrym horrorze, było już tylko straszniej i przyszła europejska polityka klimatyczna (gdzie też nikt nie przypuszczał ze będzie aż tak „dekarbonizacyjna”) i powolna, a następnie gwałtowana ofensywa źródeł. Wymagania dotyczące wprowadzania energii odnawialnej i preferencje (zarówno w formach subsydiowania np. zielonymi certyfikatami, a przede wszystkim w dostępie do sieci – obligatoryjny odbiór zielonej produkcji) skurczyły rynek i gwałtownie zmieniły sposób pracy węglówek. Nagle okazało się, że takich bloków jest nawet „za dużo” (poza kilkoma dniami największych obciążeń w mroźne zimowe dni lub w czasie ekstremalnie wysokich letnich upałów), a na dodatek muszą pracować bardzo regulacyjnie (właściwie na minimum technicznym w godzinach nocnych), a często nawet odstawiać się do stanu ciepłego na kilka, kilkanaście godzin a nawet na dni weekendowe lub świąteczne o małym zapotrzebowaniu. Typowe obciążenie polskiego bloku energetycznego jest więc bardzo zmienne – poniżej wykres jednego z 200 MW (upgrade`owanego do 225 MW) w ciągu roku.

Zarówno ilość rozruchów jak i intensywność zmian obciążenia (gradient zmian) są dużo większe niż dawniej. Elastyczność pracy staje się najbardziej wymaganym parametrem. Wobec coraz większej ilości energii z wiatru (w niektóre wietrzne dni) wymagane jest coraz niższe zejście z mocą w nocy oraz jak najszybsze podjazdy (za którą to regulacyjność płaci operator systemu).

Będzie już tylko gorzej

Wygląda na to, że jest to stan permanentny, a nawet można oczekiwać tylko pogorszenia. Kolejne moce energetyki odnawialnej – cały czas z pierwszeństwem w dostępie do sieci, będą zmuszały elektrownie do jeszcze większej regulacji, a może i powodowały więcej odstawień. Polski system nie posiada właściwie typowych mocy regulacyjnych (poza elektrowniami szczytowo-pompowymi w ograniczonym zakresie). Całość zmian muszą przyjąć na siebie elektrownie węglowe. Będą się ścigać na coraz bardziej kurczącym się rynku i chwytać się kurczowo dodatkowych przychodów z regulacji, obniżać swoje minima techniczne i pracować coraz bardziej dynamicznie. Tymczasem , jak pokazała już historia kotłów węglowych na samym początku ich powstania, są one elastyczne i regulacyjne, ale nie aż tak, żeby uczynić z tego ich podstawowy reżim pracy. Elektrownie węglowe chciałyby produkować (o ile możliwe na nominalnym poziomie obciążenia) a jeśli mają ciągle zmieniać swoją moc i ciągle się zatrzymywać i uruchamiać – na pewno będą musiały też pracować bardziej awaryjnie.

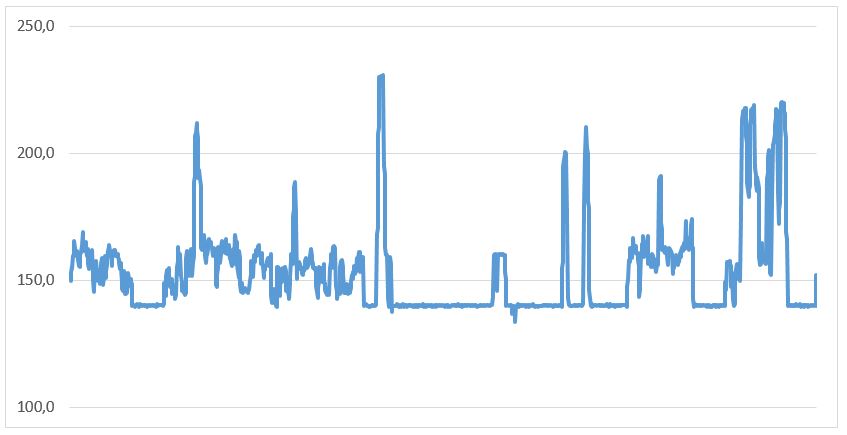

Poniżej – tydzień bez odstawienia dla bloku 200 (225) pracującego w ARCM, ale jak widać przez większą część czasu musiał on pracować w okolicach minimum technicznego (140 MW) na niskich mocach.

Starsze bloki są bardziej odporne… ale też wiekowe

Żadna maszyna nie lubi nagłych zmian obciążenia, mogą jedynie znosić to lepiej lub gorzej. Bloki węglowe mają odpowiednią liczbę uruchomień (i przekroczeń parametrów dopuszczalnych, które zdarzają się w takich stanach) i wcześniej czy później następują problemy materiałowe. Pojawiają się pęknięcia, a następnie awarie o mniejszym lub większym nasileniu. Paradoksalnie, starsze bloki są technologicznie bardziej przystosowane do zmian obciążenia, bo parametry pary nie są wygórowane. Niektóre z bloków są też praktycznie niezniszczalne, jak wyjątkowe w polskiej energetyce kotły w Elektrowni Połaniec dostarczone z syberyjskiej fabryki w Taganrogu, a więc projektowane z zapasem, większe i spalające wszystko co się tam wrzuci. Dla niektórych bloków wprowadzane są nawet kolejne rozwiązania umożliwiające zaniżanie mocy (dla popularnych 200-tek nawet zjazd do 90 MW ale na węglu kamiennym). Niestety, w większości bloki są już prawie doszczętnie wyeksploatowane. Ilość godzin pracy idzie w setki tysięcy przekraczając powoli dozwolone resursy, a ich dzisiejsza praca oparta jest o wielokrotne modernizacje. Niestety zwykle nie jest znana dokładnie historia eksploatacji (przy takim okresie pracy – czasami nawet ponad 30 lat trudno to zrobić) wobec czego nie znany jest tak naprawdę stan urządzeń, ale na pewno jest słaby. Teraz, coraz większe wymagania elastyczności na pewno nie pomogą im w dojściu do zasłużonej emerytury. Można oczekiwać tylko większej ilości awarii i pogorszenia współczynników dyspozycyjności. Dokładnych wyliczeń dla całego systemu niestety nie ma. Każdy z koncernów (spółki wytwórcze) raportuje oczywiście wewnętrznie parametry niezawodnościowe i koszty remontowe, ale chyba sam dodatkowy koszt spowodowany dużymi zmianami obciążenia i większą liczna odstawień, umyka w zestawieniach. Tymczasem w następnych 5 latach można spodziewać się wzrostu tych kosztów i to niekoniecznie tylko liniowo.

Paradoksalnie-im bardziej nowoczesny, tym gorzej

Wydawałoby się, że problem rozwiążą nowobudowane, nowoczesne bloki… ale wcale tak nie jest. Postęp technologiczny doprowadził do znacznego podwyższenia parametrów pary (przejście na bloki nadkrytyczne) oraz dzięki lepszym technikom projektowania (komputery i obliczenia) , zoptymalizował dostawy. Projektuje się więc i dostarcza bloki „szyte dokładnie na miarę”, mające znacznie mniejsze współczynniki bezpieczeństwa, niższe zapasy w grubościach ścianek czy dopuszczalnych nieprężeniach- jednak wszystko to będzie tylko szkodzić w przypadku pracy o zmiennych obciążeniach. Przykładowo, dzisiaj typowe, chińskie, duże, węglowe bloki pyłowe mocy są skrojone na pracę w podstawie obciążenia i niechętnie zmieniają moc w krótkim czasie. Tak samo będzie pewnie i w nowych polskich konstrukcjach. Pewne wyniki mamy też z uruchomionych po 2010 instalacji – wszystkie nowe konstrukcje cierpią na stosunkowo dużą ilość awarii – niewątpliwe ma na to wpływ fakt, że są projektowane na nowe, dużo wyższe parametry, ale pewnie też dlatego, że nikt nie przewidywał, że będą zmieniały swoją moc tak często i tak dynamicznie. Czarna seria dotkliwych awarii dotyka zarówno bloku fluidalnego jak i największego pyłowego, na pewno w części dzięki tak dużym wymaganiom pracy w regulacji.

Można więc prawie w ciemno założyć, że każdy nowy blok klasy 1000 MW będzie musiał często pracować częstokroć bardzo nisko (na minimum technicznym) i… że będzie miał dużo więcej awarii niż się spodziewamy.

Nowe technologie węglowe wcale nie będą się lepiej zachowywać

Dodatkowo – presja na węgiel nie pomaga. Dekarbonizacja wymusza nowe pomysły i nowe technologie, a to znowu ogranicza możliwości pracy na częściowych obciążeniach i gwałtowne zmiany mocy. Przykładowo – wzmiankowana w wypowiedziach Ministerstwa Energii, koncepcyjna technologia korzystania z gazu ze zgazowania węgla (IGCC) kompletnie nie nadaje się do dynamicznej pracy. Zarówno technologia chińska jak i japońska to bloki do pracy absolutnie w postawie na 100% obciążenia, mają jedynie możliwość krótkiego zejścia niżej, ale tylko po to żeby naprawić ewentualne, małe awarie. Nie widać tu żadnej możliwości, aby mogły działać tak jak tego wymaga nowy, polski system energetyczny – zmiennie i szybko. Paradoksalnie wprowadzanie nowego u nas nie pomaga, bo albo taki blok natychmiast będzie miał trudności eksploatacyjne, albo będzie musiał jechać na stałym obciążeniu (a więc dodatkowo wymusi większe wahania w innych blokach w systemie).

A może jednak silnie regulacyjne jednostki?

Patrząc na nowe trendy – może jednak wrócić do koncepcji dobrych, regulacyjnych jednostek, zaprojektowanych właśnie do tego celu. Praca szczytowa, szybkie uruchomienia, regulacyjność w szerokim zakresie i szybkie zmiany mocy – naturalnie preferuje to turbiny gazowe i technologie gazowe. Dodatkowo patrząc na explicite europejskie ograniczenia 550 gCO2/kWh pokazywane w nowych propozycjach europejskiego rynku – powoli staje się to nieuniknione. Przedstawiona niedawno koncepcja prof. Mielczarskiego, aby nie budować już więcej wielkich bloków, a zwrócić uwagę na jednostki dedykowane do regulacji – wydaje się przewidywać nowe trendy. Może więc zamiast do końca w okopach bronić nowych, wielkich bloków energetycznych na węgiel, warto uczyć się na historii, a nawet na historii techniki i energetyki. W końcu węgiel (kocioł pyłowy) nie przebił się do napędu lokomotyw i statków, bo wymagania ruchowe były zupełnie inne. Może więc warto wrócić do koncepcji zbudowania porządnych zasobów mocy szczytowej i regulacyjnej (nawet potencjalnie droższej w produkcji energii), aby nasze, nowe, węglowe jednostki doprowadzić do pracy w podstawie obciążenia, a nie płacić w przyszłości wielkie koszty remontowe?